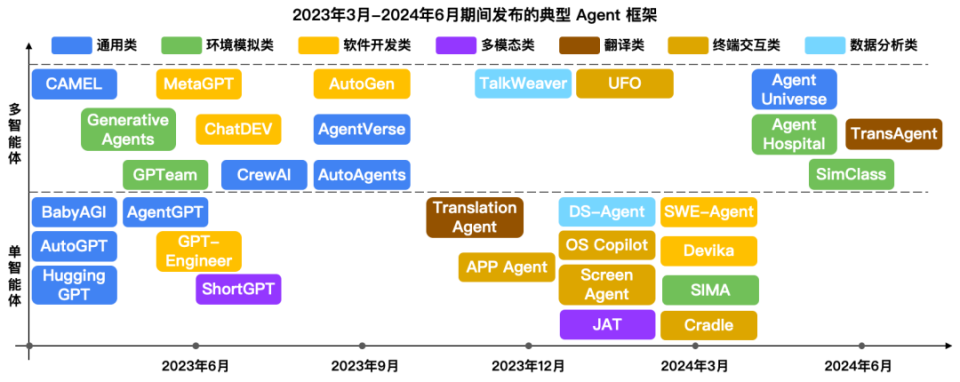

國內軟件科技領域迎來了一波AI Agent產品的發布熱潮,短短時間內已有近50款相關產品問世,覆蓋了智能客服、辦公助手、行業顧問、個性化推薦等多個場景。這一現象既彰顯了市場對人工智能技術落地的熱情,也引發了一個核心的追問:當前的技術發展水平,是否足以支撐這些產品在實際應用中的可靠性與穩定性?

從技術開發的視角審視,AI Agent的可靠性建立在幾個關鍵的技術支柱之上。首先是核心的模型能力。得益于大語言模型(LLM)技術的快速發展,特別是中文理解與生成能力的顯著提升,國產基礎模型在語義理解、邏輯推理、任務規劃等方面取得了長足進步。這為Agent提供了“大腦”,使其能夠更準確地理解用戶意圖、分解復雜任務。模型固有的“幻覺”問題(即生成看似合理但不準確或虛假的信息)、對長上下文處理的穩定性、以及特定領域知識的深度和時效性,仍然是影響Agent輸出可靠性的主要技術挑戰。許多產品在簡單、封閉場景下表現良好,但在開放、動態或高專業要求的真實業務環境中,其表現可能出現波動。

其次是智能體(Agent)框架與工程化能力。一個可靠的AI Agent不僅僅是調用大模型API,更是一個集成了規劃、記憶、工具調用、多輪對話管理、安全與合規校驗等模塊的復雜系統。國內開發者在基于國外開源框架(如LangChain、AutoGPT)進行快速迭代和本土化創新的也在自主研發更適應中文環境和國內業務邏輯的Agent框架。工程化的關鍵在于如何將這些模塊穩健地集成,確保系統在高并發下的響應速度、在多步驟任務執行中的錯誤恢復能力、以及在與外部工具、數據庫、API交互時的穩定與安全。目前,許多產品仍處于快速原型驗證或小范圍試用階段,其架構在面對大規模、高復雜度的真實生產環境壓力時,其魯棒性和可維護性仍需經過更長時間的考驗。

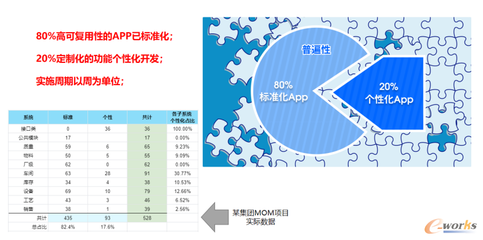

再者是數據與反饋閉環。AI Agent的持續優化和可靠性提升,高度依賴于高質量的訓練數據、精調(Fine-tuning)以及基于真實用戶交互的強化學習(RLHF/RLAIF)。國內企業雖然在數據積累方面有場景優勢,但如何構建高效、合規的數據管道,清洗和標注高質量的對齊數據,并設計有效的在線學習與迭代機制,是技術落地的深水區。缺乏持續、優質反饋閉環的產品,其性能可能停滯不前,甚至隨著業務變化而退化。

最后是生態與標準初現。眾多產品的涌現也催生了對中間件、評估基準、測試工具和行業標準的需求。目前,針對AI Agent的可靠性、安全性、性能的評估體系尚不完善,缺乏公認的、貼合中國應用場景的測試標準。這導致用戶難以橫向比較不同產品的真實可靠度,也增加了企業選型和集成的風險。

國內AI Agent產品的密集問世,反映了技術探索和市場需求的雙輪驅動。當前的技術基礎——特別是在大模型能力、基礎框架搭建上——已經為應用提供了可行的起點,使得在諸多垂直和輕度場景中部署相對可靠的Agent成為可能。要支撐起在關鍵業務、復雜流程和高可靠性要求場景下的規模化、高可信應用,技術層面仍面臨諸多挑戰:需要進一步攻克核心模型的可靠性短板,提升Agent系統工程化的成熟度,構建可持續進化的數據與訓練閉環,并逐步建立完善的評估與標準體系。

因此,對于“技術是否足夠支撐應用可靠性”這一問題,答案或許是“初步支撐,但遠未成熟”。當前階段是產品百花齊放、場景快速驗證的“上半場”,而決定勝負的“下半場”將取決于各廠商如何深耕技術細節,夯實工程基礎,在真實的商業閉環中持續打磨產品的穩定性和價值深度,從而將技術潛力轉化為堅實可靠的生產力。